SoC 기반 AI 가속기 – 브로드컴 vs. 마벨 협력사 비교

안녕하세요.

약사 와이프와 함께하는 히픽입니다.

오늘 남겨볼 이야기는요,

결국 빅테크 기업들은 자신들이 칩을 만들지만 SoC 기업들과 협업을 하게 됩니다.

아마존, 마이크로소프트, 메타 등등 여러 회사들이 말이죠.

그래서 그런 업체들은 어떻게 협업하는지 궁금해서 정리해본 내용입니다.

SoC 기반 AI 가속기 – 브로드컴 vs. 마벨 협력사 비교

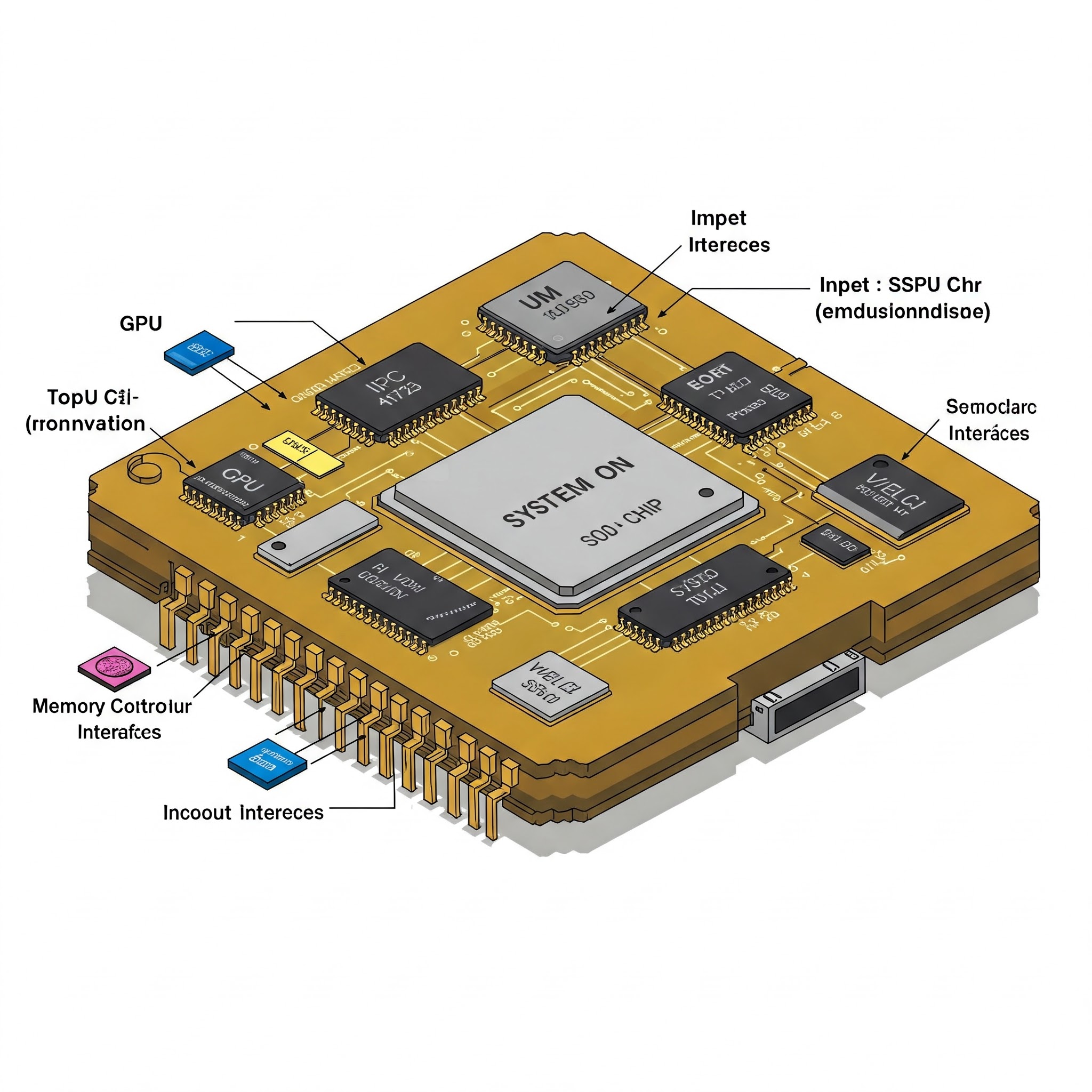

AI 가속기 시장에서 SoC(System on Chip) 기반 AI 반도체가 점점 중요해지고 있습니다. 기존 AI 가속기(예: GPU, ASIC)들은 연산 성능을 극대화하는 데 초점을 맞췄지만, SoC 기반 AI 가속기는 특정 AI 워크로드에 최적화된 **맞춤형 설계(Custom Design)**가 가능합니다.

특히, 주요 클라우드 및 빅테크 기업들은 브로드컴(Broadcom) 또는 마벨(Marvell)과 협력하여 맞춤형 AI 칩을 개발하고 있습니다. 이번 글에서는 브로드컴과 마벨이 협력하는 업체들과 각 SoC 기반 AI 가속기의 특징을 비교해 보겠습니다.

1. SoC 기반 AI 가속기란?

SoC 기반 AI 가속기는 CPU, 메모리, 네트워크 인터페이스 등을 하나의 칩에 통합한 AI 전용 반도체입니다. 기존 GPU 및 AI ASIC보다 전력 효율성이 높고, 특정 AI 모델이나 서비스에 맞춰 설계할 수 있습니다.

✅ SoC 기반 AI 가속기의 특징

- 맞춤형(Custom) 설계 가능 → 특정 AI 워크로드(추론, 추천 모델 등)에 최적화

- 전력 효율성 우수 → 데이터센터에서 전력 소모 절감 가능

- 메모리 & 네트워크 통합 → 고속 데이터 처리에 최적화

AI 서비스가 다양해지면서, 빅테크 기업들은 엔비디아 GPU만 사용하는 것이 아니라 자체 SoC 기반 AI 가속기를 개발하고 있으며, 이 과정에서 브로드컴 또는 마벨과 협력하고 있습니다.

2. 브로드컴(Broadcom)과 협력하는 AI 칩 제조업체

✅ 브로드컴 협력사의 주요 특징

- 주로 메타(Meta), 구글(Google) 등과 협력

- AI 추천 모델 및 클라우드 서비스 최적화

- 강력한 네트워크 기술과 결합 → 데이터센터용 AI 칩으로 활용

🔹 구글 TPU (Tensor Processing Unit)

- 구글은 자체 AI 가속기 TPU 시리즈를 개발 중이며, 최근 TPU v5까지 출시

- 브로드컴과 협력하여 네트워크 최적화 및 고속 연산이 가능한 SoC 설계

- TPU는 훈련(Training)보다 추론(Inference)에 최적화

🔹 메타(Meta)의 MTIA (Meta Training & Inference Accelerator)

- 메타는 AI 추천 시스템을 가속화하기 위해 MTIA 칩 개발

- 브로드컴과 협력하여 네트워크 및 메모리 최적화

- GPU보다 전력 효율성이 뛰어나 광고 추천 시스템 등에 활용

✅ 브로드컴 협력사의 강점: 네트워크 최적화 + AI 추론 성능 강화

🚨 단점: 훈련(Training) 성능은 GPU 대비 부족

3. 마벨(Marvell)과 협력하는 AI 칩 제조업체

✅ 마벨 협력사의 주요 특징

- 마이크로소프트(Microsoft), 아마존(AWS) 등과 협력

- 대규모 AI 클러스터에서 활용

- HBM과 고속 인터커넥트 기술 활용

🔹 마이크로소프트의 Maia AI 칩

- 마이크로소프트(Microsoft)는 자체 AI 가속기 Maia 개발 중

- 마벨과 협력하여 HBM 메모리를 최적화하고, AI 훈련 성능을 높임

- 클라우드 AI 모델(예: ChatGPT, 코파일럿) 훈련에 활용

🔹 아마존 AWS의 Trainium & Inferentia

- 아마존(AWS)은 AI 모델 훈련용 Trainium, 추론용 Inferentia 개발

- 마벨과 협력하여 전력 효율성과 비용 최적화

- AWS 클라우드에서 AI 가속기로 사용됨

✅ 마벨 협력사의 강점: 훈련(Training) + 추론(Inference) 최적화

🚨 단점: 네트워크 최적화에서는 브로드컴 대비 약점

4. 브로드컴 vs. 마벨 – AI 칩 협력사 비교 정리

항목 브로드컴(Broadcom) 협력사 마벨(Marvell) 협력사

| 주요 파트너 | 구글(TPU), 메타(MTIA) | 마이크로소프트(Maia), 아마존(AWS) |

| 주요 AI 워크로드 | AI 추천, 검색, 광고 | AI 모델 훈련 + 클라우드 AI |

| 네트워크 최적화 | ✅ 강점 (데이터센터 최적화) | 🔺 상대적으로 약함 |

| 훈련(Training) 성능 | 🔺 상대적으로 약함 | ✅ 강점 (대형 AI 모델 훈련 가능) |

| 추론(Inference) 성능 | ✅ 강점 (전력 효율 우수) | ✅ 강점 (AWS Inferentia 최적화) |

| HBM 활용 | 제한적 | ✅ 적극 활용 |

| 주요 고객사 활용 방식 | 자체 서비스 최적화 (검색, 추천) | AI 클라우드 서비스 가속화 |

5. 결론 – SoC 기반 AI 가속기의 향후 전망

현재 AI 가속기 시장은 엔비디아 GPU가 절대적인 강자이지만, SoC 기반 AI 가속기의 수요도 빠르게 증가하고 있습니다.

🔹 브로드컴 협력사(구글, 메타) → AI 추천 및 검색 서비스 최적화

🔹 마벨 협력사(마이크로소프트, AWS) → 대규모 AI 훈련 및 클라우드 AI 서비스 최적화

📌 AI 모델이 점점 커지면서, SoC 기반 AI 가속기의 역할이 더욱 커질 것으로 예상됩니다.

📌 브로드컴 vs. 마벨 경쟁 구도가 AI 데이터센터 및 클라우드 서비스 시장을 어떻게 변화시킬지 주목해야 합니다!

'IT World' 카테고리의 다른 글

| 삼성전자 vs. SK하이닉스 – HBM(고대역폭 메모리) 경쟁 구도 정리 (0) | 2025.03.16 |

|---|---|

| 엔비디아 vs. AMD – AI 가속기 경쟁 구도 정리 (0) | 2025.03.14 |

| 쉽게 이해하는 AI 가속기 트렌드 – GPU, HBM, 그리고 ASIC (0) | 2025.03.09 |

| 빗썸 예측차트: 암호화폐 투자에 도움이 되는 필수 도구 (0) | 2025.02.01 |

| 갤럭시 S23 eSIM 설정 방법 (0) | 2024.03.20 |